隨著云計算技術的深入發展,云原生(Cloud Native)已成為構建和運行現代化應用的主流范式。它將應用的構建、部署、運維與底層基礎設施解耦,強調彈性、可觀測性和韌性。而在萬物互聯、實時響應需求日益增長的今天,云原生的理念與實踐正加速向網絡邊緣延伸,深刻影響著邊緣設備上的應用軟件服務形態。

一、 云原生的核心與邊緣的適配

云原生的核心通常圍繞容器(如Docker)、編排(如Kubernetes)、微服務、服務網格(如Istio)和聲明式API構建。這些技術旨在實現應用的敏捷開發、持續交付和自動化運維。

當這一套理念落地到邊緣側時,面臨獨特的挑戰與機遇:

- 資源受限:邊緣設備(如工業網關、車載終端、智能攝像頭)的算力、內存和存儲通常遠不及云端數據中心。這意味著完整的Kubernetes發行版可能過于“笨重”,需要輕量化方案(如K3s、KubeEdge、MicroK8s)或更精簡的運行時。

- 網絡不穩定:邊緣與云端、邊緣節點之間的網絡連接可能時斷時續、帶寬有限。這要求應用服務具備離線自治能力,能夠獨立處理本地數據與請求,并在網絡恢復時進行高效的協同與同步。

- 分布式與異構性:邊緣環境由海量、地理位置分散且硬件架構(x86, ARM)各異的設備組成。應用軟件服務需要能夠被統一地分發、部署和管理,同時兼容不同的運行環境。

- 實時性與數據本地化:許多邊緣場景(如工業控制、自動駕駛)對延遲極其敏感,且出于隱私、法規或效率考慮,數據需要在本地或近端處理。這催生了“計算跟隨數據”的模式,應用服務必須能夠被動態調度到最合適的位置。

二、 邊緣側的應用軟件服務新范式

在上述背景下,邊緣側的應用軟件服務呈現出新的特點:

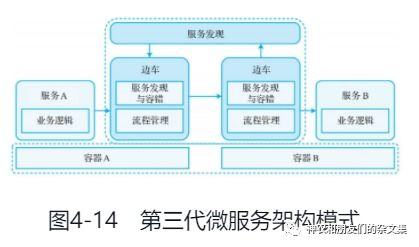

- 微服務的極致化與重構:傳統的微服務在邊緣側可能需要進一步拆分或合并,以匹配單一設備的處理能力。服務間的通信協議可能更傾向于輕量級的MQTT、CoAP等,而非HTTP/REST。服務網格在邊緣的部署模式也需簡化,可能僅保留核心的流量治理和安全功能。

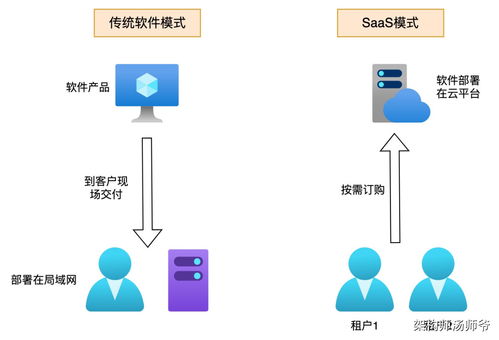

- 應用即“工件”,聲明式部署:應用及其依賴被封裝為不可變的容器鏡像或更輕量的格式(如WebAssembly模塊)。通過聲明式的清單文件(如Kubernetes YAML),開發者可以定義應用在邊緣集群中的期望狀態——需要多少實例、部署在哪些節點(通過節點標簽選擇)、需要多少資源。邊緣側的編排器(如K3s Agent)負責自動拉取鏡像、創建容器并維持狀態。

- 混合編排與協同:典型的模式是“云端管控,邊緣運行”。云端有一個集中的控制平面(如Kubernetes Master),負責應用編排、策略下發和全局視圖;邊緣節點作為工作節點,運行實際的服務負載。兩者通過安全的通道通信,實現“一次定義,隨處運行”。這為大規模邊緣應用管理提供了可行性。

- 狀態管理與數據服務:有狀態應用在邊緣的部署更具挑戰。需要結合本地存儲(如HostPath PV)、分布式存儲方案或與邊緣數據庫(如SQLite、EdgeX Foundry)集成。數據服務可能需要具備流處理、本地緩存和向云端批處理同步的能力。

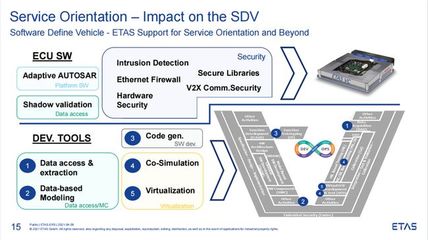

- 安全與生命周期管理:邊緣設備暴露在物理不可控的環境中,安全至關重要。這包括容器鏡像的安全掃描、運行時的安全隔離(如Seccomp, AppArmor)、服務間的mTLS認證,以及設備本身的身份認證與準入控制。應用服務的全生命周期(監控、日志收集、自動伸縮、滾動更新)也需在資源約束下實現。

三、 實踐觀察與展望

在實踐中,我們看到:

- 輕量化K8s發行版成為主流橋梁:K3s等項目成功地將K8s的API和管理能力帶到了資源受限的邊緣,是當前實現邊緣云原生應用服務的關鍵技術棧。

- Serverless理念的滲透:事件驅動的函數計算(如OpenFaaS在邊緣的部署)為某些邊緣數據處理場景提供了更簡潔的編程模型,進一步抽象了基礎設施。

- 標準化與開源生態的演進:LF Edge旗下的Akraino、EdgeX Foundry等項目正致力于構建邊緣計算的開源框架和標準接口,推動應用服務的互操作性。

- AI模型作為特殊服務:在邊緣側,訓練好的AI模型常被封裝為獨立的推理服務(通過容器或專用運行時),通過服務網格進行調用,實現智能的本地化。

隨著5G、算力網絡和硬件虛擬化技術的發展,邊緣設備的能力將持續增強。應用軟件服務將更加智能化、自適應和自治,能夠根據網絡條件、負載情況和業務需求,在云、邊、端之間無縫遷移和協同,真正實現無處不在的智能計算。對于開發者而言,掌握云原生技術棧,并深刻理解其在邊緣環境的變體與約束,是構建下一代分布式應用的關鍵。